El sector financiero se enfrenta a un nuevo desafío con la aparición de los deepfakes, una técnica que permite crear videos y audios falsos de gran realismo.

Ley de Inteligencia Artificial de la UE: un hito en la regulación de la tecnología del futuro

El 13 de marzo de 2024, el Parlamento Europeo marcó un hito histórico al aprobar la Ley de Inteligencia Artificial (IA), convirtiéndose en el primer regulador del mundo en establecer un marco jurídico completo sobre esta tecnología disruptiva al categorizar los sistemas de IA en función de sus riesgos e impacto potenciales.

E

sta ley, cuyo texto definitivo se publicará en abril de 2024 y su aplicación total tendrá lugar a lo largo de los próximos dos años, tiene como objetivo garantizar que la IA se desarrolle y utilice de forma responsable, segura y ética en la Unión Europea.

Antecedentes: un camino hacia la regulación

Los últimos años han sido testigos de un avance vertiginoso en el campo de la Inteligencia Artificial, con aplicaciones que abarcan desde el reconocimiento facial hasta la conducción autónoma pasando, cómo no, por la IA generativa. Sin embargo, este rápido progreso ha generado también preocupaciones sobre los posibles riesgos asociados a la IA, como la discriminación, la falta de transparencia y el uso indebido.

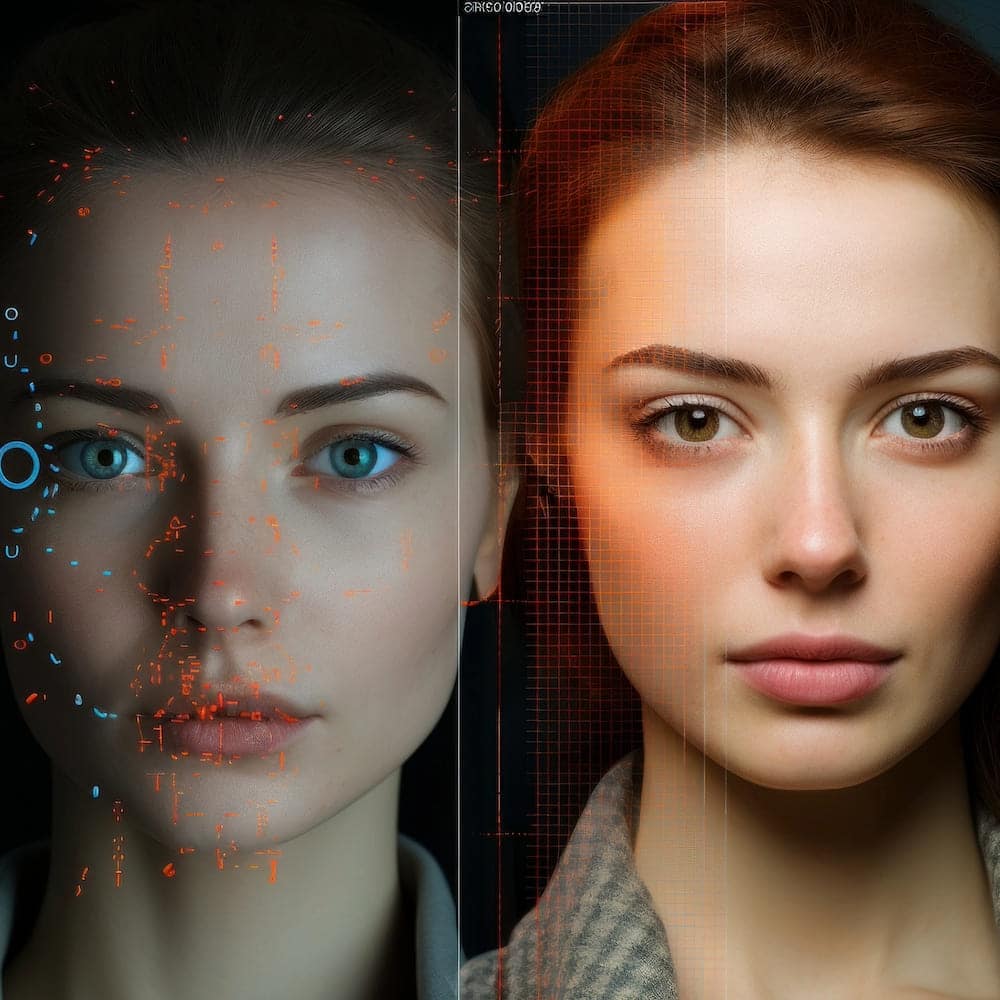

Uno de estos riesgos, quizá el más notable, es el deepfake: una técnica de inteligencia artificial que se utiliza para crear videos o imágenes falsas que parecen auténticas, generalmente mediante la sustitución del rostro de una persona en un contenido audiovisual por el de otra persona, utilizando algoritmos de aprendizaje automático y procesamiento de imágenes. TrustCloud aplica IA para la detección de deepfakes tanto en los procesos de identificación y reconocimiento facial en tiempo real como en el análisis retrospectivo de datos. Abarca tanto imagen como vídeo y está respaldada por un equipo de expertos en inteligencia artificial y seguridad cibernética que trabaja constantemente para mantenerse al día con las últimas tendencias y técnicas de generación de deepfakes. La detección automática de deepfakes que plantea TrustCloud protege la identidad de las personas y blinda los procesos de video identificación, integrándose con fluidez dentro de transacciones complejas.

En respuesta a estas preocupaciones, la Comisión Europea presentó en 2020 una propuesta de Ley de IA, que fue posteriormente debatida y modificada por el Parlamento Europeo y el Consejo Europeo. La aprobación final de la ley en marzo de 2024 representa la culminación de un largo proceso de deliberación que busca establecer un marco legal sólido en este campo.

Pero ¿qué entendemos por IA? Uno de los puntos clave durante la negociación del texto fue encontrar la definición más adecuada de Inteligencia Artificial. Al final, se decidió utilizar:

«Sistema basado en máquinas diseñado para operar con distintos niveles de autonomía y que puede mostrar capacidad de adaptación tras su despliegue y que, para objetivos explícitos o implícitos, infiere, a partir de los estímulos que recibe, cómo generar respuestas tales como predicciones, contenidos, recomendaciones o decisiones que pueden influir en entornos físicos o virtuales».

Objetivos y propósito: hacia una IA beneficiosa para la sociedad

La Ley europea establece como objetivo principal garantizar que los sistemas de IA se desarrollen y utilicen de manera que beneficien a la sociedad en su conjunto. Para ello, la ley busca promover los siguientes objetivos:

- Proteger los derechos humanos y las libertades fundamentales: La IA no debe utilizarse de manera que discrimine o perjudique a las personas.

- Garantizar la seguridad y la protección: Los sistemas de IA deben ser diseñados para ser seguros contra ciberataques y otras amenazas.

- Promover la transparencia y la responsabilidad: Las personas deben tener derecho a saber cómo se utiliza la IA y quién es responsable de su funcionamiento.

- Fomentar la innovación y el desarrollo responsable: La ley debe crear un entorno propicio para las inversiones y la innovación responsable.

Niveles de riesgo: un enfoque proporcional

Uno de los puntos más interesantes y que más ha concentrado el debate en torno a la ley es el criterio a la hora de considerar una IA “peligrosa” o que “excede” su utilidad para convertirse en una herramienta de control. A este respecto, La ley establece cuatro niveles de riesgo para clasificar los sistemas de Inteligencia Artificial y define las regulaciones correspondientes a cada uno.

- Riesgo Inaceptable: Se prohíben terminantemente las aplicaciones que utilizan técnicas subliminales, sistemas de explotación o sistemas de puntuación social utilizados por las autoridades. Esto significa que queda prohibido el empleo de sistemas que rastrean y analizan de forma masiva los datos personales de las personas para evaluar su comportamiento, generar perfiles o tomar decisiones que afecten a sus vidas. Se busca evitar la creación de «estados de vigilancia» donde la IA se utilice para controlar y manipular a la población. También se prohíben los sistemas de identificación biométrica remota a tiempo real utilizados por las fuerzas del orden en espacios públicos para la vigilancia masiva de ciudadanos.

- Riesgo Alto: Las aplicaciones relacionadas con el transporte, la educación, el empleo y el bienestar social, entre otras, entran en esta categoría. También los sistemas de identificación biométrica. Estos sistemas de IA pueden potencialmente crear un efecto adverso en la salud, la seguridad o los derechos fundamentales de una persona. Las empresas que pretendan comercializar o desplegar un sistema de IA de alto riesgo en la UE deberán someterse a una «evaluación de conformidad» previa y cumplir una serie de requisitos para garantizar la seguridad del sistema. Como medida práctica, el reglamento obliga a la Comisión Europea a crear y mantener una base de datos pública donde los proveedores deberán informar sobre sus sistemas de IA de alto riesgo, garantizando la transparencia para las partes interesadas.

- Riesgo Limitado: Se refiere a los sistemas de IA que cumplen con obligaciones específicas de transparencia. Por ejemplo, un individuo que interactúa con un chatbot debe ser informado de que está hablando con una máquina para que pueda decidir si continúa (o solicita hablar con un humano en su lugar). Los sistemas de IA destinados a interactuar con personas físicas o a generar contenidos pueden plantear riesgos específicos de suplantación de identidad o engaño, con independencia de que se califiquen o no como sistemas de IA de alto riesgo.

- Riesgo Mínimo: Estas aplicaciones ya están ampliamente implementadas y constituyen la mayoría de los sistemas de IA con los que interactuamos hoy en día. Algunos ejemplos son los filtros de spam, los videojuegos con IA y los sistemas de gestión de inventario.

Prohibiciones de la Ley de Inteligencia Artificial

El reglamento establece una serie de prohibiciones contundentes que buscan proteger los valores fundamentales de la Unión Europea y prevenir el uso indebido de esta poderosa tecnología. Estas prohibiciones abordan prácticas específicas que podrían generar graves consecuencias negativas para la sociedad.

La toma de decisiones automatizadas basadas en algoritmos de IA debe estar exenta de cualquier sesgo o discriminación. La ley prohíbe el uso de sistemas de IA que tomen decisiones que discriminen a las personas por motivos de raza, etnia, género, orientación sexual, religión, discapacidad o cualquier otra característica protegida por la ley. Se busca garantizar la igualdad de trato y la no discriminación en todos los ámbitos donde se implemente la IA.

La ley prohíbe el uso de la IA para manipular las emociones o el comportamiento de las personas. Esto incluye técnicas como la microsegmentación, la publicidad personalizada basada en perfiles psicológicos o el uso de bots para difundir información falsa o propaganda. Se busca proteger la autonomía y la libertad de las personas frente a la manipulación algorítmica y garantizar que la IA no se utilice para influir indebidamente en sus decisiones o comportamientos.

La ley exige que los sistemas de IA sean transparentes y auditables. Esto significa que debe ser posible conocer cómo funcionan estos sistemas, qué datos utilizan, qué decisiones toman y con qué criterios.

IA en el futuro: responsabilidad y servicio social

El texto representa un paso fundamental para garantizar que la IA se desarrolle y utilice de manera responsable, segura y ética en la Unión Europea. La ley tiene el potencial de impulsar la innovación, fomentar la confianza en la tecnología y contribuir a la creación de un futuro más beneficioso para la sociedad en su conjunto. No obstante, cualquier marco normativo de este tipo no puede ser ajeno al escrutinio de la ciudadanía. Cada paso debe ser seguido de cerca para que la Inteligencia Artificial no deje de ser una herramienta humanista y de progreso.

El marco pretende garantizar las posibilidades y limitar al máximo los riesgos. Europa se ha esforzado para que sea lo suficientemente flexible como para comprender tecnologías o funciones en el futuro, de manera que sea sencillo amoldarse a los cambios que pueda haber. De todas maneras, algunos Estados miembros están valorando normas “nacionales” para enmendar ciertos aspectos o garantizar la seguridad de puertas para adentro. Esta decisión podría provocar el efecto contrario: inseguridad para proveedores y usuarios de servicios debido a contradicciones en la aplicación.

La implementación y el éxito de la ley dependerán en gran medida de la cooperación entre diferentes actores, como gobiernos, empresas, investigadores y sociedad civil. Es fundamental trabajar juntos para garantizar que la IA se utilice de manera que beneficie a todos y que se respeten los valores fundamentales de la Unión Europea.

Podemos ayudarte a implementar procesos a medida para tus transacciones digitales seguras y cumplir con los últimos estándares de cumplimiento.

Contacta ahora con nuestros especialistas y solicita un asesoramiento personalizado